Reapariția agendelor naționaliste din întreaga lume poate să indice o diminuare a capacității sistemului multilateral de a juca un rol semnificativ în guvernarea globală a AI. Corporațiile majore și statele membre puternice pot avea puțină valoare în a aborda abordări multilaterale în ceea ce privește ceea ce consideră tehnologii profitabile și proprietare.

Sistemul multilateral trebuie să contribuie urgent la construirea unui nou contract social pentru a se asigura că inovarea tehnologică, în special inteligența artificială (AI), este implementată în condiții de siguranță și aliniată la nevoile etice ale unei lumi globalizate.

Swarms of bots, posturi întunecate Facebook și site-uri de știri false au revendicat teritoriul online, cu repercusiuni semnificative la nivel global. Luați în considerare doar câteva evenimente recente: în alegerile prezidențiale din 2016 din SUA, Rusia a împuternicit un candidat față de altul printr-o campanie masivă care includea anunțuri plătite, conturi false de social media și conținut polarizator.

În China, giganții tehnici Alibaba și Tencent au desfășurat milioane de camere echipate cu recunoaștere facială pentru a comodifica fluxurile continue de date intime despre cetățeni. În Myanmar, un raport al ONU a confirmat că posturile de pe Facebook au alimentat discursul violent despre ură adresat musulmanilor Rohingya.

Alianța puternică și lucrativă dintre AI și o societate bazată pe date a transformat rețelele sociale în arhitecți ai schimburilor noastre, noii maeștri remodificând chiar țesătura realității.

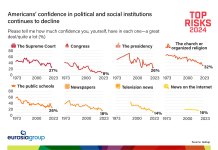

În acest context, anxietatea publică crește în legătură cu pierderea controlului asupra unei revoluții algoritmice, care pare să scape de modurile noastre de înțelegere și responsabilitate. Încrederea în guvernarea națională și globală este la punctul de rupere.

În același timp, tehnologiile bazate pe AI vor avea tendința de a submina, mai degrabă decât de a impune, mecanisme de guvernanță globală. ONU se confruntă cu o mulțime de provocări interdependente. Să ne uităm la trei.

AI și degradarea adevărului

În primul rând, AI este inerent o tehnologie cu dublă utilizare a cărei implicații puternice (atât pozitive cât și negative) vor fi din ce în ce mai dificil de anticipat, de restrâns și de atenuat.

Luați Deepfake ca exemplu. Programele AI sofisticate pot manipula acum sunete, imagini și clipuri video, creând impersonații care sunt adesea imposibil de distins de original. Deep-learning algoritmii pot, cu o precizie surprinzătoare, să citească buzele umane, să sintetizeze vorbirea și, într-o oarecare măsură, să simuleze expresiile faciale.

Odată eliberați în afara laboratorului, astfel de simulări ar putea fi folosite cu ușurință cu impacturi largi (într-adevăr, acest lucru se întâmplă deja la un nivel scăzut). În ajunul alegerilor, videoclipurile de la Deepfake ar putea reprezenta în mod fals funcționarii publici implicați în spălarea banilor; panica publică ar putea fi semănată cu videoclipuri care avertizează despre epidemii sau cyberattacks inexistente; iar incidentele forjate ar putea duce la o escaladare internațională.

Capacitatea unui grup de actori de a influența opinia publică cu simulări înșelătoare ar putea avea implicații puternice pe termen lung pentru rolul ONU în pace și securitate. Prin erodarea sentimentului de încredere și a adevărului între cetățeni și stat – și într-adevăr între state – știrile cu adevărat fals ar putea fi profund corosive pentru sistemul nostru de guvernanță globală.

AI și supraveghere de precizie

În al doilea rând, AI deja conectează și converg cu o serie de alte tehnologii, inclusiv biotehnologie, cu implicații semnificative pentru securitatea globală. Sistemele AI din întreaga lume sunt instruite pentru a prezice diferite aspecte ale vieții noastre de zi cu zi prin înțelegerea unor seturi masive de date, cum ar fi modelele de trafic ale orașelor, piețele financiare, datele privind tendințele comportamentului consumatorilor, înregistrările medicale și chiar genomii noștri.

Aceste tehnologii AI sunt din ce în ce mai capabile să valorifice datele comportamentale și biologice în moduri inovatoare și adesea manipulative, cu implicații pentru noi toți. De exemplu, papusa inteligentă a prietenului meu Cayla trimite date vocale și emoționale ale copiilor care se joacă cu ea în nor, ceea ce a condus la o plângere a Comisiei Federale a Comerțului și interdicția acesteia în Germania. În SUA, analiza emoțională este deja utilizată în sala de judecată pentru a detecta remușcări în filmele de depunere. În curând, ar putea face parte din interviurile de angajare pentru a evalua răspunsurile candidaților și capacitatea acestora de a-și găsi un loc de muncă.

Capacitatea AI de a intruda – și potențial de a controla – comportamentul uman privat are implicații directe asupra agendei ONU în domeniul drepturilor omului. Noi forme de control social și de bio-control ar putea necesita, de fapt, o reimaginare a cadrului în vigoare pentru monitorizarea și punerea în aplicare a Declarației Universale a Drepturilor Omului și va impune cu siguranță sistemului multilateral să anticipeze mai bine și să înțeleagă acest domeniu rapid.

Bătălia AI

În cele din urmă, capacitatea tehnologiilor bazate pe AI de a influența populațiile mari este de o valoare atât de imediată și superioară încât este aproape sigur că este teatrul viitoarelor conflicte. Există o perspectivă foarte reală a unei “rase cibernetice” în care națiunile puternice și platformele tehnologice mari intră în concurență deschisă pentru datele colective, ca și combustibil pentru a genera supremație economică, medicală și de securitate pe tot globul. Forme de “colonizare cibernetică” sunt din ce în ce mai probabil, deoarece statele puternice sunt capabile să exploateze AI și biotehnologia pentru a înțelege și a controla potențial populațiile și ecosistemele altor țări.

Spre guvernarea globală a AI

Din punct de vedere politic, juridic și etic, societățile noastre nu sunt pregătite pentru desfășurarea AI. Iar ONU, înființată cu multe decenii înainte de apariția acestor tehnologii, este în multe moduri prost plasată pentru a dezvolta genul de guvernare responsabilă care va canaliza potențialul AI departe de aceste riscuri și față de siguranța colectivă și bunăstarea noastră.

De fapt, reapariția agendelor naționaliste din întreaga lume poate să indice o diminuare a capacității sistemului multilateral de a juca un rol semnificativ în guvernarea globală a AI. Corporațiile majore și statele membre puternice pot avea puțină valoare în a aborda abordări multilaterale în ceea ce privește ceea ce consideră tehnologii profitabile și proprietare.

Dar există câteva modalități inovatoare în care ONU poate contribui la construirea unor rețele de colaborare și transparente care ar putea începe să ne trateze “tulburarea deficitului de încredere”.

Promovat de un mandat acordat Universității Națiunilor Unite (UNU) în cadrul Strategiei Secretarului General privind noile tehnologii, Centrul de Cercetare Politică al UNU a creat o “platformă AI și o platformă globală de guvernare” ca un spațiu cuprinzător pentru cercetători, politici actori, lideri corporativi și gânditori, pentru a explora provocările politice globale ridicate de inteligența artificială.

De la observațiile globale ale liderilor din domeniu, platforma urmărește să încurajeze cunoștințele interdisciplinare unice pentru a informa dezbaterile existente din cadrul obiectivului multilateralismului, împreună cu lecțiile de pe teren. Aceste informații vor sprijini statele membre ale ONU, agențiile multilaterale, fondurile, programele și alte părți interesate, având în vedere atât propriile lor, cât și rolurile lor colective în modelarea guvernării AI.

Poate că cea mai importantă provocare pentru ONU în acest context este una de relevanță, de a restabili un sentiment de încredere în sistemul multilateral. Dar, dacă tendințele de mai sus ne spun ceva, tehnologiile bazate pe AI sunt o problemă pentru fiecare individ și fiecare stat și că, fără forme colective de colaborare, există un risc real ca acestea să submineze stabilitatea globală.

sursa: wold economic forum